LangChainでPDFを“学習”→OpenAI APIごとに性能を評価しました

はじめに

株式会社cross-Xの古嶋です。DX戦略の立案やデータ・AI活用の支援をしています。

今回は、OpenAI APIのgpt-4及びgpt-3.5-turboの性能について比較してみたので、その検証結果をご紹介します。かなり簡易的な検証結果であり、より踏み込んだ精査が求められるところもありますが、面白い示唆が得られたので記事としてまとめた次第です。

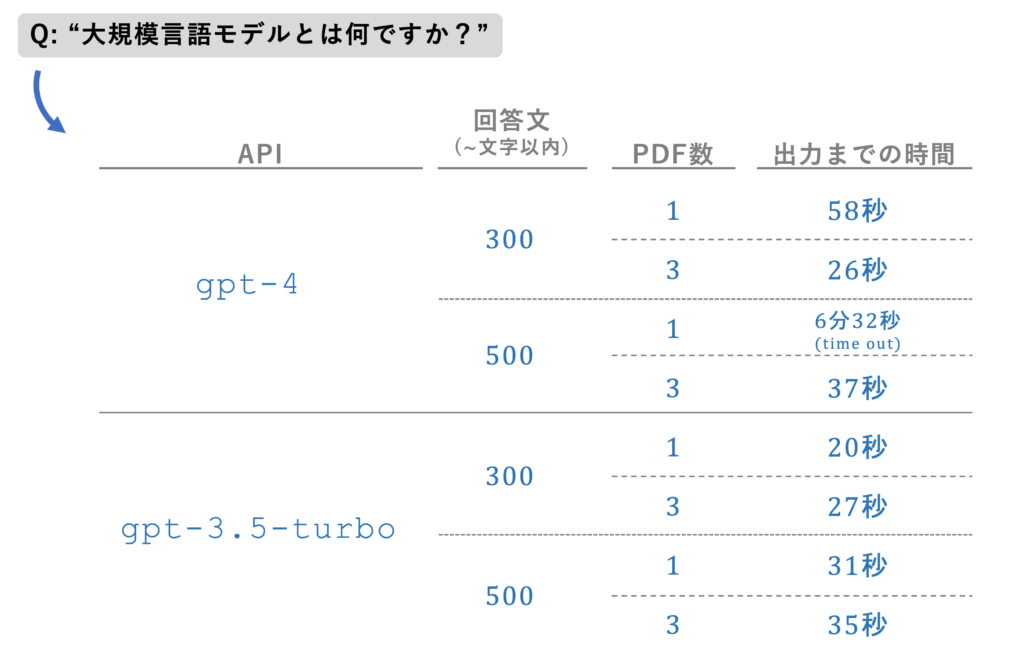

では、早速ですが下図を御覧ください。

これは、最近話題のLangChainを利用してOpenAIのAPIにコンテキスト内学習(ICL: In Context Learning)を実行し、PDF内に記載されている情報を抽出して回答を得るという手法を用いた場合の「出力までの時間」を比較したものです。

その中で、以下の3つの軸で「出力までの時間」を評価しています。

- API: gpt-4またはgpt-3.5-turboの場合で比較

- 回答文: プロンプトに「〜文字以内で答えてください」と指示し、その長さを300字以内と500字以内で比較

- PDF数: ICLの対象とするPDF数を1個または3個の場合で比較

その結果、結論から言うと、以下のように非常に興味深い結果が得られました。

- 検索対象となるPDF数を1個から3個に増やすと、gpt-4の場合は出力までの時間が大幅に短縮される。逆に、gpt-3.5-turboの場合は出力までの時間が若干長くなる。

- gpt-4の場合、ファイル数が1個だけだと、質問文に対する回答文を長文で出力することが難しくなる。

- ファイル数が3個の場合、gpt-4とgpt-3.5-turboのそれぞれの出力までの時間の差はわずか数秒となる。

これは、よくよく考えると直感に反している現象で非常に面白いですね。

ChatGPTを利用していると、gpt-4とgpt-3.5-turboだと前者の方が出力が遅いことは、使ったことがあれば明白だと思います。しかし、ICLのアプローチで用いる情報量を増やすと、gpt-4とgpt-3.5-turboでは出力にかかる時間がほとんど差がつかなくなるかもしれないということです。この点は実務上、大いに検証すべきポイントです。

ここまでは出力までの速さについて整理した内容ですが、肝心の出力内容の「質」についてはどうでしょうか?

「与えられたPDFファイルの情報を質問内容に沿ってまとめる」というタスクにおいて、もし、出力も速くて得られる回答の質も差がないのであれば、運用上、gpt-3.5-turboの方が低コストで運用可能です。

ということで、ここからは、上記の手法で得られた出力を列挙し、簡単な比較と考察をしていきます。サンプル数や検証方法の種類としてはかなり簡易的ですが、何かの参考となれば幸いです。

出力内容を質的に比較する

この検証では以下の3つの論文を対象としました。それぞれ大規模言語モデル(LLM)を対象とした論文です。

- A Survey of Large Language Models

- Harnessing the Power of LLMs in Practice: A Survey on ChatGPT and Beyond

- Is Prompt All You Need? No. A Comprehensive and Broader View of Instruction Learning

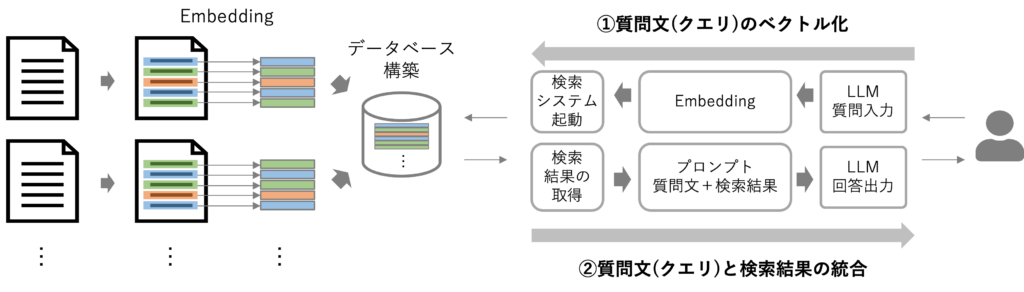

これらを用いて出力を得るまでの概観は、おおよそ下図の通りです。詳しくはこちらの記事を御覧ください。

それぞれのAPIには以下の質問文を入力しました。PDFファイル数を1つまたは3つとして検証するため、あまりにも情報量に差が出てしまうと検証にならないため、どのファイルにも共通して解説されている点に言及した質問文としています。

"What is LLMs? Answer within X00 words."

(LLMsとは何ですか?X00文字以内で回答しなさい。)

文中のXには、3または5の数字を入れて指示内容を変えています。それでは、検証結果を見ていきましょう。

PDFは1種類のみで、300文字の出力依頼の場合

このケースでは、A Survey of Large Language Modelsのみを対象としてプロンプトを実行しました。APIごとの出力結果は下記の通りです。また、出力文は英語で取得し、DeepLで日本語訳したものを記載しています。

gpt-3.5-turboの場合:

出力までの時間→20秒

LLM(大規模言語モデル)は、人工知能(AI)モデルの一種で、大量のテキストデータで学習させ、自然言語を理解し、与えられたプロンプトに基づき高品質のテキストを生成します。このモデルは、数千億(またはそれ以上)のパラメータを含み、非常に深いニューラルネットワークに多頭の自己注意層を積み重ねたTransformerアーキテクチャをベースに構築されています。\LLMの最大の特徴は、その創発的な能力であり、小さなモデルには存在しないが、大きなモデルで発生する能力である。文脈内学習、命令追従、段階的推論などの能力があり、モデルサイズが一定以上になると発生する。\LLMは、医療、教育、法律などさまざまな領域に応用されており、医療相談、標準化テストの生徒レベルの成績、法律文書の分析などのタスクで有望な結果を示している。しかし、LLMの信頼性やプライバシー、誤情報の捏造や不正行為に利用される可能性などが懸念されているのも事実です。\LLMは、自然言語処理における重要な進歩であり、人間が情報にアクセスし対話する方法に革命をもたらす可能性がある。しかし、これらのモデルの課題と限界に対処し、責任ある利用を保証するためには、さらなる研究が必要です。

gpt-4の場合:

出力までの時間→58秒

Large Language Models (LLM) は、人間のようなテキストを理解し生成するために設計された深層学習モデルの一種です。様々な自然言語処理(NLP)タスクにおいて素晴らしいパフォーマンスを発揮することから、近年大きな注目を集めています。LLMは一般的に、積み重ねられたマルチヘッド自己アテンション層からなるTransformerアーキテクチャを使用して構築されています。LLMの成功の鍵は、数十億ものパラメータを含むその大きなサイズにあります。LLMの成功の鍵は、その大きさにあり、多くの場合、数十億のパラメータを含んでいます。これにより、言語における複雑なパターンと関係を捉えることができ、文脈内学習、命令追従、ステップバイステップの推論などの創発的な能力を導くことができます。LLMの有名な例としては、OpenAIのGPT-3やGoogleのBERTなどがあります。LLMは事前学習と呼ばれるプロセスを通じて学習され、前の単語から文中の次の単語を予測するように学習します。この教師なし学習は、モデルが言語に対する一般的な理解を得るのに役立ちます。LLMは、事前学習後、対象タスクに関連するラベル付きデータで学習することで、感情分析、機械翻訳、質問応答などの特定のタスクに微調整することができます。LLMは、その優れた性能にもかかわらず、懸念や課題もあります。LLMは、訓練や配備に計算コストがかかり、サイズが大きいため解釈や理解が困難です。さらに、LLMは、現実世界に存在するバイアスを含む可能性のある学習対象データから学習するため、時として偏った内容や有害な内容を生成する可能性があります。Transformerアーキテクチャを使用して構築され、大量のデータで学習されるため、数十億のパラメータを持つモデルが得られます。LLMは様々なNLPタスクにおいて大きな可能性を示していますが、計算コスト、解釈可能性、潜在的なバイアスに関連する課題や懸念も抱えています。

この両者の相違点について、ChatGPTに以下のプロンプトで質問しました。

以下の2つの文章は、それぞれ「LLMsとは何ですか?」という質問に対して、gpt-3.5-turboとgpt-4によって出力された文書です。 それぞれの文章について共通点と相違点を整理してください。

- gpt-3.5-turboによる出力:

(上記の文章を入力) - gpt-4による出力:

(上記の文章を入力)

すると、以下の回答が得られました。

共通点

- 両方の文章は、LLM(大規模言語モデル)について説明しています。

- 両方の文章は、LLMが自然言語処理(NLP)タスクにおいて優れた性能を発揮することを強調しています。

- 両方の文章は、LLMがTransformerアーキテクチャを使用し、数十億のパラメータを含むことを説明しています。

- 両方の文章は、LLMが文脈内学習、命令追従、段階的推論などの創発的な能力を持つことを述べています。

- 両方の文章は、LLMに関連する課題や懸念があることを指摘しています。

相違点

- gpt-3.5-turboの出力では、LLMが医療、教育、法律などの分野で応用され、有望な結果を示していることを強調していますが、gpt-4の出力では具体的な分野への言及はありません。

- gpt-4の出力では、LLMの事前学習プロセスや教師なし学習による一般的な言語理解の獲得、さらに特定のタスクへの微調整について説明していますが、gpt-3.5-turboの出力ではこの点に言及していません。

- gpt-4の出力では、GPT-3やBERTなどの有名なLLMの例が挙げられていますが、gpt-3.5-turboの出力では具体的なモデルの名前は挙げられていません。

- gpt-3.5-turboの出力では、LLMに関連する懸念事項として信頼性、プライバシー、誤情報の捏造や不正行為の利用可能性に触れていますが、gpt-4の出力では計算コスト、解釈可能性、潜在的なバイアスが主な懸念事項として挙げられています。

上記を踏まえると、このケースの場合では、2つのAPIを使い分けるというより、双方のAPIで得られた出力を統合して解釈するほうが良い、と言えそうです。

PDFは1種類のみで、500文字の出力依頼の場合

このケースも同様に見ていきましょう。

gpt-3.5-turboの場合:

出力までの時間→31秒

LLM(大規模言語モデル)は、人工知能(AI)モデルの一種で、大量のテキストデータで学習され、数千億(またはそれ以上)のパラメータを含んでいます。LLMは、Transformerアーキテクチャをベースに構築されており、このアーキテクチャは、非常に深いニューラルネットワークの中で、積み重ねられたマルチヘッド自己アテンション層で構成されています。LLMは、自然言語を理解し、与えられたプロンプトに基づいて高品質のテキストを生成することができます♪LLMの最大の特徴の1つは、その創発能力です。このような能力は、モデルサイズがあるレベルを超えたときにのみ観測され、モデルサイズに対して性能が大きく上昇するスケーリング則で部分的に記述することができます。LLMは、大規模なMixed-of-Sourceコーパスで事前学習されており、事前学習データから豊富な知識を取り込むことができる。このため、LLMは特定の分野の専門家であり、最近の研究では、LLMをドメイン固有のタスクの解決に使用することが検討され、その適応能力が評価されています。LLMは、検索エンジンやレコメンダーシステムなど、人間の情報アクセス方法を変える可能性を持っています。また、知的な情報アシスタントとして利用される可能性もあり、これまで以上にスマートな知的システムの開発につながる可能性があります。しかし、この開発プロセスでは、AIの安全性を第一に考え、AIが人類にとって良い方向に進み、悪い方向に進まないようにする必要があります。Transformerアーキテクチャをベースに構築されており、自然言語を理解し、与えられたプロンプトに基づいて高品質のテキストを生成することができる。LLMは、小さなモデルにはなく、大きなモデルで生じる創発的な能力を持ち、医療、教育、法律など様々な領域で応用されています。LLMは、人間が情報にアクセスする方法を変える可能性があり、これまで以上にスマートな知的システムの開発につながる可能性があるが、AIの安全性を第一に考慮する必要がある。

gpt-4の場合:

出力までの時間→6分32秒

Time out

この場合、gpt-4のAPIでは6分を超えても出力が得られず、アクセスがタイムアウトしました。5回ほど繰り返しても同様の結果であったため、gpt-4の場合、文字数を多く要求した出力の場合だと、回答を得づらいのかもしれません。

ただし、後ほど言及しますが、参照する情報数が増えると、gpt-4はgpt-3.5-turboに比肩するレベルの出力スピードを発揮します。

PDFは3種類で、300文字の出力依頼の場合

情報ソースとなるPDFファイル数を3個に増やしました。この場合、どうなるでしょうか?

gpt-3.5-turboの場合:

出力までの時間→27秒

LLM(大規模言語モデル)は、数千億以上のパラメータを含み、膨大なテキストデータで学習される言語モデルです。LLMは、Transformerアーキテクチャをベースに構築されており、このアーキテクチャは、非常に深いニューラルネットワークの中で、積み重ねられたマルチヘッド自己アテンション層で構成されています。LLMは自然言語を理解し、与えられた文脈やプロンプトに基づいて高品質のテキストを生成することができる。\LLMの最大の特長は、「創発能力」である。この能力には、文脈内学習、命令追従、ステップバイステップの推論が含まれる。文脈内学習は、LLMが追加の学習や勾配更新を必要とせずに、入力テキストの単語列を完成させてテストインスタンスに対する期待出力を生成することを可能にする。インストラクションフォローは、LLMが明示的な例を用いずにタスクの指示を理解することで、新しいタスクを実行することを可能にし、その汎化能力を大きく向上させることができる。ステップバイステップ推論とは、LLMが論理と証拠に基づいたステップバイステップの推論を行うことで、複雑な推論タスクを実行することを可能にします。これらの問題を軽減するために、研究者は、外部ツールやモデルによってLLMの生成プロセス全体をガイドする、推論プロセスや最終回答を再チェックして修正する、特に算術演算を扱う外部ツールを取り入れるなど、さまざまな解決策を提案しています♪LLMを評価するために、研究者はSuperGLUE、MMLU、BIGベンチ、HELMなどのベンチマークを提案しています。これらのベンチマークは、数学、コンピュータサイエンスから人文科学、社会科学に至るまで、幅広い知識領域をカバーしています。これらのベンチマークは、言語理解、質問応答、推論など、さまざまなタスクにおけるLLMのパフォーマンスを評価します。\結論として、LLMは自然言語処理のための強力なツールとして登場した大規模な言語モデルである。LLMには、これまでの言語モデルとは異なるいくつかの新しい能力がありますが、複雑な推論タスクを解決することには限界があります。研究者たちは、様々なタスクにおけるLLMのパフォーマンスを評価するために、様々なソリューションやベンチマークを提案してきた。

gpt-4の場合:

出力までの時間→26秒

LLM(大規模言語モデル)は、数千億以上のパラメータを含み、膨大なテキストデータで学習される言語モデルです。LLMは、Transformerアーキテクチャをベースに構築されており、このアーキテクチャは、非常に深いニューラルネットワークの中で、積み重ねられたマルチヘッド自己アテンション層で構成されています。LLMは自然言語を理解し、与えられた文脈やプロンプトに基づいて高品質のテキストを生成することができる。\LLMの最大の特長は、「創発能力」である。この能力には、文脈内学習、命令追従、ステップバイステップの推論が含まれる。文脈内学習は、LLMが追加の学習や勾配更新を必要とせずに、入力テキストの単語列を完成させてテストインスタンスに対する期待出力を生成することを可能にする。インストラクションフォローは、LLMが明示的な例を用いずにタスクの指示を理解することで、新しいタスクを実行することを可能にし、その汎化能力を大きく向上させることができる。ステップバイステップ推論とは、LLMが論理と証拠に基づいたステップバイステップの推論を行うことで、複雑な推論タスクを実行することを可能にします。これらの問題を軽減するために、研究者は、外部ツールやモデルによってLLMの生成プロセス全体をガイドする、推論プロセスや最終回答を再チェックして修正する、特に算術演算を扱う外部ツールを取り入れるなど、さまざまな解決策を提案しています♪LLMを評価するために、研究者はSuperGLUE、MMLU、BIGベンチ、HELMなどのベンチマークを提案しています。これらのベンチマークは、数学、コンピュータサイエンスから人文科学、社会科学に至るまで、幅広い知識領域をカバーしています。これらのベンチマークは、言語理解、質問応答、推論など、さまざまなタスクにおけるLLMのパフォーマンスを評価します。\結論として、LLMは自然言語処理のための強力なツールとして登場した大規模な言語モデルである。LLMには、これまでの言語モデルとは異なるいくつかの新しい能力がありますが、複雑な推論タスクを解決することには限界があります。研究者たちは、様々なタスクにおけるLLMのパフォーマンスを評価するために、様々なソリューションやベンチマークを提案してきた。

両者の出力について、共通点と相違点をChatGPTに質問したところ、次の回答が得られました。

共通点

- 両方の出力は、LLM(大規模言語モデル)について説明しており、数千億以上のパラメータを含む言語モデルであることを強調しています。

- 両方とも、LLMがTransformerアーキテクチャに基づいて構築されていることを説明しています。

- どちらの出力も、LLMが自然言語を理解し、与えられた文脈やプロンプトに基づいて高品質のテキストを生成できると述べています。

- 両方の文章で、LLMの最大の特長として「創発能力」が挙げられており、文脈内学習、命令追従、ステップバイステップの推論が含まれていることが説明されています。

- 両方の出力は、LLMの評価のためにSuperGLUE、MMLU、BIGベンチ、HELMなどのベンチマークが提案されていることを述べています。

- どちらの文章も、LLMが強力な自然言語処理ツールであるものの、複雑な推論タスクには限界があることを結論付けています。

相違点

- 実際には、両方の出力には目立った相違点はありません。これは、どちらの出力も同じ質問に対してほぼ同じ情報を提供しており、LLMに関する説明が一貫しているためです。ただし、文の構造や表現が若干異なる場合がありますが、その違いは意味的な違いではなく、単に言い回しの違いに過ぎません。

参照するファイル数が増えてくると、両者のAPIによる出力内容に差があまり表れなくなってきました。

それでは、出力の文字数を増やすとどうなるでしょうか?次で検証してみましょう。

PDFは3種類で、500文字の出力依頼の場合

最も情報量が多く、出力への要求も大きいケースです。この場合はどうでしょうか?

gpt-3.5-turboの場合:

出力までの時間→35秒

LLM(大規模言語モデル)は、数千億以上のパラメータを含み、膨大なテキストデータで学習される言語モデルです。LLMは、Transformerアーキテクチャをベースに構築されており、非常に深いニューラルネットワークの多頭自己アテンション層が積み重なって構成されています。LLMは自然言語を理解し、与えられた文脈やプロンプトに基づいて高品質のテキストを生成することができる。\LLMの最大の特徴は、「創発的能力」である。この能力は、モデルサイズがあるレベルを超えたときに初めて観測されるもので、物理学における相転移に類似している。LLMの代表的な出現能力として、文脈内学習、命令追従、ステップバイステップ推論の3つがある。\文脈内学習とは、LLMが入力テキストの単語列を完成させることで、追加の学習や勾配更新を必要とせず、テストインスタンスに対して期待通りの出力を生成する能力のことである。インストラクション・フォローとは、LLMが明示的な例を用いることなく、タスクの指示を理解することで新しいタスクを実行できるようにすることで、汎化能力を大きく向上させることができる。ステップバイステップ推論とは、LLMが複雑な推論タスクを、より小さく扱いやすいステップに分解して実行する能力のことである。\LLMは、言語モデリング、機械翻訳、質問応答、テキスト分類など、さまざまな自然言語処理タスクに適用されている。これらのタスクの多くで最先端の性能を達成し、小型モデルを大幅に上回ることが示されています。\LLMの性能を評価するために、SuperGLUE、MMLU、BIG-bench、HELMなどのベンチマークが提案されている。これらのベンチマークは、自然言語推論、質問応答、テキスト分類など、LLMの評価において主流となる様々な評価タスクをカバーしています。\LLMは、その優れた性能の反面、著作権や個人情報の漏洩、偏見や差別など、法的な課題も指摘されています。さらに、LLMの台頭は、これまで以上にスマートな知的システムの開発が期待されている人工知能(AGI)の探究にも光を当てています。しかし、この開発プロセスにおいて、AIの安全性は主要な懸念事項の1つであるべきで、AIが人類にとって良い方向に向かうように、しかし悪い方向に向かわないようにする必要があります。\結論として、LLMは自然言語処理タスクの強力なツールとして登場した大規模言語モデルである。LLMはTransformerアーキテクチャをベースに構築されており、自然言語を理解し、与えられたコンテキストやプロンプトに基づいて高品質のテキストを生成することができる。LLMは、多くの自然言語処理タスクで最先端の性能を達成し、いくつかのベンチマークを使用して評価されています。しかし、法的課題やAIの安全性についての懸念も生じています。

gpt-4の場合:

出力までの時間→37秒

LLM(大規模言語モデル)は、数千億以上のパラメータを含み、膨大なテキストデータで学習される言語モデルの一種である。LLMは、Transformerアーキテクチャをベースに構築されており、非常に深いニューラルネットワークの多頭自己アテンション層を積み重ねることで構成されています。LLMは自然言語を理解し、与えられた文脈やプロンプトに基づいて高品質のテキストを生成することができる。\LLMの最大の特徴は、「創発的能力」である。この能力は、モデルサイズがあるレベルを超えたときに初めて観測されるもので、物理学における相転移に類似している。LLMの代表的な出現能力として、文脈内学習、命令追従、ステップバイステップ推論の3つがある。\文脈内学習とは、LLMが入力テキストの単語列を完成させることで、追加の学習や勾配更新を必要とせず、テストインスタンスに対して期待通りの出力を生成する能力のことである。インストラクション・フォローとは、LLMが明示的な例を用いることなく、タスクの指示を理解することで新たなタスクを実行できるようにすることで、汎化能力を大きく向上させることができる。ステップバイステップ推論とは、LLMが複雑な推論タスクを、より小さく扱いやすいステップに分解して実行する能力のことである。\LLMは、言語モデリング、機械翻訳、質問応答、テキスト分類など、さまざまな自然言語処理タスクに適用されている。これらのタスクの多くで最先端の性能を達成し、小型モデルを大幅に上回ることが示されています。\LLMの性能を評価するために、SuperGLUE、MMLU、BIG-bench、HELMなどのベンチマークが提案されている。これらのベンチマークは、自然言語推論、質問応答、テキスト分類など、LLMの評価において主流となる様々な評価タスクをカバーしています。\LLMは、その優れた性能の反面、著作権や個人情報の漏洩、偏見や差別など、法的な課題も指摘されています。さらに、LLMの台頭は、これまで以上にスマートな知的システムの開発が期待されている人工知能(AGI)の探究にも光を当てています。しかし、この開発プロセスにおいて、AIの安全性は主要な懸念事項の1つであるべきで、AIが人類にとって良い方向に向かうように、しかし悪い方向に向かわないようにする必要があります。\結論として、LLMは言語モデルの一種であり、多くの自然言語処理タスクで最先端の性能を達成している。LLMはTransformerアーキテクチャをベースに構築されており、自然言語を理解し、与えられた文脈やプロンプトに基づいて高品質のテキストを生成することができる。LLMは、文脈内学習、命令追従、ステップバイステップの推論など、小さなモデルには存在しないが、大きなモデルで発生する能力を有している。LLMの性能を評価するために、いくつかのベンチマークが提案されており、様々な主流の評価タスクをカバーしています。しかし、LLMは、法的課題やAIの安全性についての懸念も提起している。

これまでと同様、両者の出力について、共通点と相違点をChatGPTに質問したところ、次の回答が得られました。

共通点

- 両者ともLLM(大規模言語モデル)について説明しており、数千億以上のパラメータを含むことを強調しています。

- LLMがTransformerアーキテクチャをベースに構築されていることを指摘しています。

- LLMが自然言語を理解し、与えられた文脈やプロンプトに基づいて高品質のテキストを生成できることを説明しています。

- 文脈内学習、命令追従、ステップバイステップ推論といったLLMの代表的な能力について触れています。

- 言語モデリング、機械翻訳、質問応答、テキスト分類など、さまざまな自然言語処理タスクでLLMが適用されており、最先端の性能を達成していることを説明しています。

- SuperGLUE、MMLU、BIG-bench、HELMなどのベンチマークを用いてLLMの性能が評価されていることを述べています。

- LLMに関連する法的課題やAIの安全性についての懸念があることを指摘しています。

相違点

- gpt-3.5-turboの出力では、「LLMは自然言語処理タスクの強力なツールとして登場した大規模言語モデルである」と述べていますが、gpt-4の出力では、「LLMは言語モデルの一種であり、多くの自然言語処理タスクで最先端の性能を達成している」と述べています。gpt-3.5-turboの出力はLLMの重要性を強調していますが、gpt-4の出力はより一般的な説明になっています。

- gpt-3.5-turboの出力では、文脈内学習、命令追従、ステップバイステップ推論が「LLMの最大の特徴」であると述べていますが、gpt-4の出力では、「LLMの代表的な出現能力」として述べています。表現が異なりますが、両者ともこれらの能力の重要性を認識しています。

なんと、ここでも両者の出力の差には大差がないことが分かってきました。

出力は500文字で、PDFは1種類と3種類で分けた場合

最後に、gpt-3.5-turboについて、出力は500文字とした場合、PDFファイル数の違いで出力にどのように差がでるか、既出の内容をもとに再度比較をChatGPTに依頼すると、以下の出力を得ました。

共通点

- 両文書とも、LLM(大規模言語モデル)はAIモデルの一種であり、数千億以上のパラメータを含んでいることを述べています。

- LLMは、Transformerアーキテクチャをベースに構築されており、非常に深いニューラルネットワークで構成されていると両文書で説明されています。

- 両文書とも、LLMが自然言語を理解し、与えられたプロンプトに基づいて高品質のテキストを生成することができると述べています。

- 両文書とも、LLMの開発プロセスにおいて、AIの安全性が重要な懸念事項であることを指摘しています。

相違点

- PDF1個の場合では、LLMの創発能力がモデルサイズがあるレベルを超えたときにのみ観測されると述べていますが、PDF3個の場合では創発的能力が相転移に類似していると説明しています。

- PDF1個の場合では、LLMがMixed-of-Sourceコーパスで事前学習されていると述べていますが、PDF3個の場合ではその点について触れていません。

- PDF1個の場合では、LLMが様々な領域で応用されていることを述べていますが、PDF3個の場合では自然言語処理タスクに適用されていることを説明しています。

- PDF3個の場合では、文脈内学習、命令追従、ステップバイステップ推論というLLMの代表的な創発能力について詳細に説明していますが、PDF1個の場合ではその点について触れていません。

- PDF3個の場合では、LLMの性能評価のためにSuperGLUE、MMLU、BIG-bench、HELMなどのベンチマークが提案されていることを述べていますが、出PDF1個の場合ではその点について触れていません。

- PDF3個の場合では、LLMがもたらす法的課題(著作権や個人情報の漏洩、偏見や差別)を指摘していますが、PDF1個の場合ではその点について触れていません。

- PDF3個の場合では、LLMが言語モデリング、機械翻訳、質問応答、テキスト分類などの自然言語処理タスクに適用され、多くのタスクで最先端の性能を達成していると述べていますが、PDF1個の場合ではその点について触れていません。

- PDF3個の場合では、LLMが小型モデルを大幅に上回る性能を示していると述べていますが、PDF1個の場合ではその点について触れていません。

相違点に着目すると、やはりPDFファイル数を増やしたほうが情報量が増えている様子がみ見られます。これは期待通りの結果、と言えそうです。

おわりに

今回の検証を踏まえると、「参照するファイルから情報を得るためにICLによって出力を得る」というプロセスを採用する場合は、ファイル数を増やせば、gpt-4とgpt-3.5-turboの双方で大差はなくなるかもしれない、という仮説がたてられます。もしこの仮説が立証されれば、コスト感を踏まえるとgpt-3.5-turboによる運用が妥当と言えるかもしれません。

ただし、逆に、ファイル数をさらに増やしていくと結果が変わる可能性もあります。つまり、情報数が一定量を超えると、APIによって出力に差が生まれてくる可能性がある、ということです。

また、今回の情報ソースとしたファイルはLLMに関する論文であり、テーマを変えると結果も変わるかもしれません。

一方、いずれにせよ、この文書をベクトルDB化して検索対象とし、ICLのアプローチでLLMに入力する情報として活用するという手法は、今後あらゆる領域で非常に強力なソリューションとなる可能性があると実感しました。今後も検証を進め、今回のように都度記事としてご紹介していければと思います。

最後までお読み頂き、ありがとうございました。皆さまの実務において、何かしらのヒントになれば幸いです。